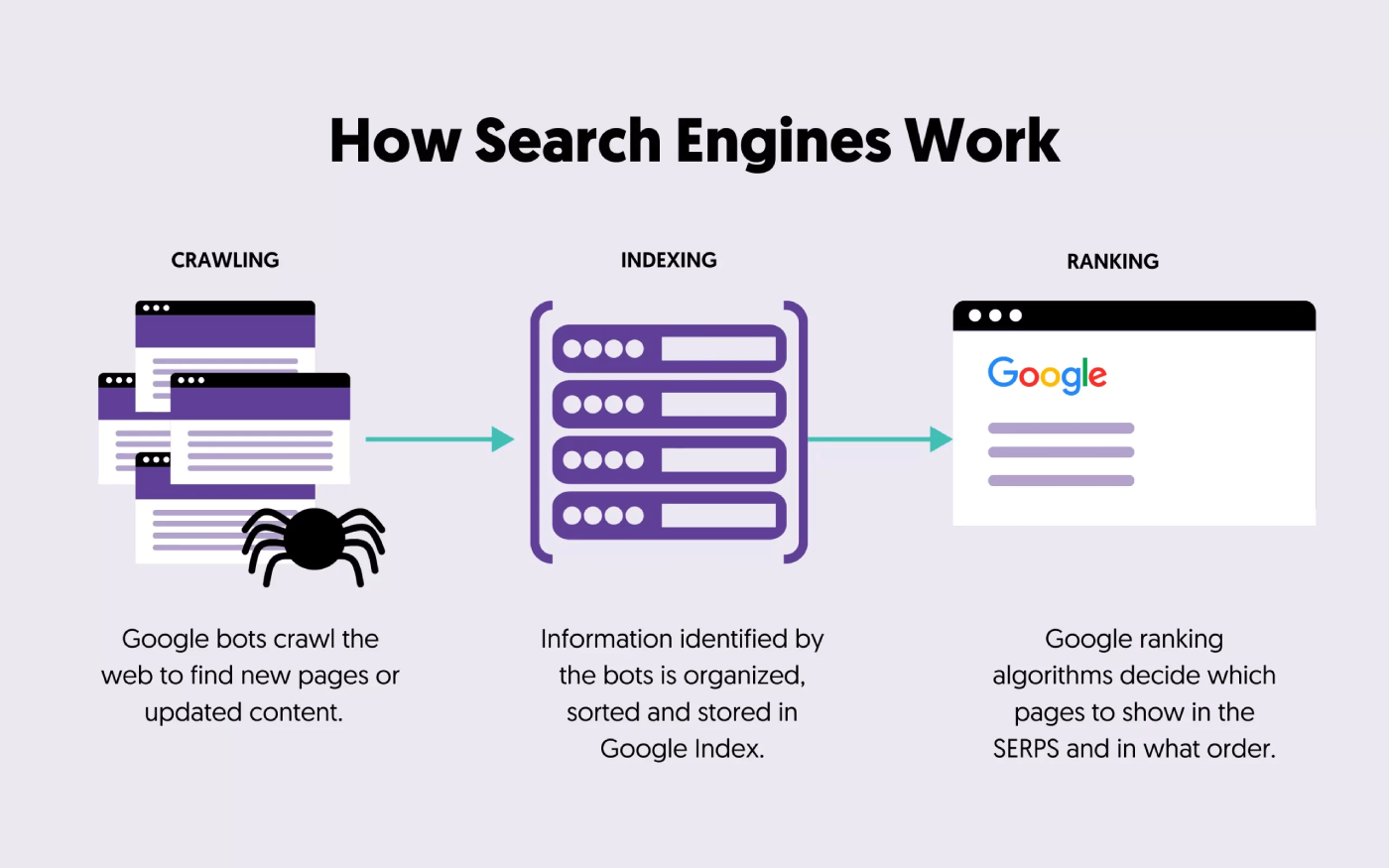

Crawl dybde påvirker, hvor effektivt Google kan indeksere dit indhold.

Googlebot har begrænset tid og serverressourcer. Derfor er crawl-budgettet, eller antallet af sider Googlebot kan crawle på dit site i en bestemt tidsramme, begrænset.

Crawl dybde påvirker også brugeroplevelsen. Besøgende kan have svært ved at få adgang til de nødvendige oplysninger, hvis væsentligt indhold er svært at finde på grund af kompleks navigation eller overdreven dybde.

I denne artikel vil jeg forklare, hvad [crawl depth] betyder, og hvorfor det er vigtigt i [SEO].

Plus, jeg vil dele nogle tips til at hjælpe dig med at forbedre din hjemmesides [crawl depth] for bedre søgemaskinepræstation.

Hvad er Crawl Depth i SEO?

Crawl dybde refererer til niveauet eller afstanden, en webside er placeret inden for en hjemmesides hierarki, målt fra hjemmesiden.

Det repræsenterer, hvor mange klik eller trin en søgemaskines webcrawler tager for at nå en bestemt side fra webstedets hjemmeside. Crawl-dybde er vigtig, fordi det kan påvirke hvor effektivt søgemaskiner opdager og indekserer dit websteds indhold.

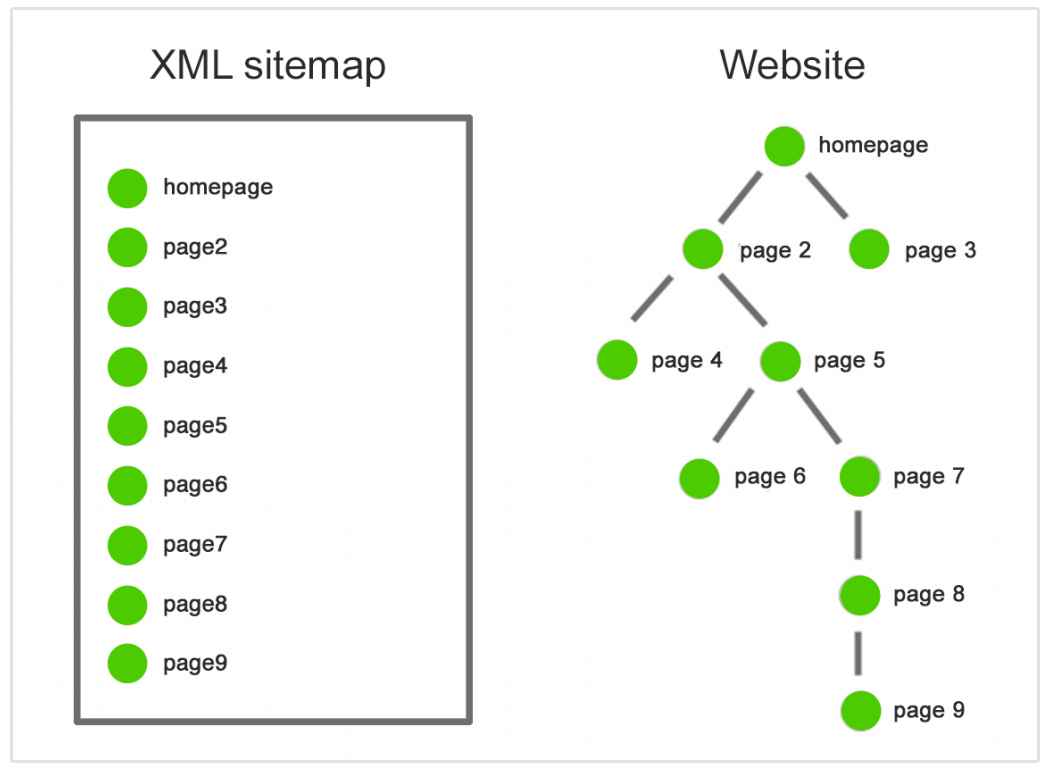

Forestil dig, at du har en hjemmeside med følgende struktur:

Hjemmeside > Kategori A > Underkategori A1 > Side 1

Hjemmesiden har en crawl-dybde på 0 i dette eksempel, fordi det er udgangspunktet. Underkategori A1 har en crawl-dybde på 2, fordi det er to klik fra hjemmesiden, og Side 1 har en crawl-dybde på 3, fordi det er tre klik væk fra hjemmesiden.

Hvorfor er Crawl Depth vigtig i SEO?

Crawl dybde betyder noget i SEO af flere grunde:

- Indekseringseffektivitet: Sider begravet dybt inden for en websites struktur bliver muligvis ikke crawlet og indekseret så ofte som dem tættere på hjemmesiden.

- Link Equity: Sider tættere på hjemmesiden modtager ofte mere link equity (autoritet) gennem interne og eksterne links. Dette kan påvirke deres placeringer og synlighed i søgemaskiner.

- Brugeroplevelse: En kompleks og dyb webstedsstruktur kan gøre det udfordrende for brugere og søgemaskiner at finde vigtigt indhold, hvilket potentielt kan føre til en dårlig brugeroplevelse.

- Friskhed: Sider med en lav crawl-dybde er mere tilbøjelige til at blive crawlet hyppigt, hvilket gør det muligt for søgemaskiner at opdage og indeksere opdateringer og ændringer hurtigere.

Hvordan man øger effektiviteten af crawl-dybde

Her er nogle af de bedste måder at forbedre crawl-dybde effektiviteten på:

Opdater regelmæssigt sitemap

Ved at indsende dit sitemap, gør du det lettere for søgemaskiner at crawle og indeksere dine websider hurtigt.

Det er afgørende at understrege, at sitemaps skal forblive dynamiske og altid afspejle den mest opdaterede status for din hjemmeside.

Husk at opdatere dit sitemap i overensstemmelse hermed, når du tilføjer nye sider, opdaterer eksisterende eller fjerner forældet indhold. Dette sikrer, at søgemaskiner altid har adgang til en nøjagtig og omfattende liste over din hjemmesides URL'er.

Forbedre webstedsnavigation og struktur

Forbedring af din hjemmesides navigation og struktur er grundlæggende for webdesign og SEO.

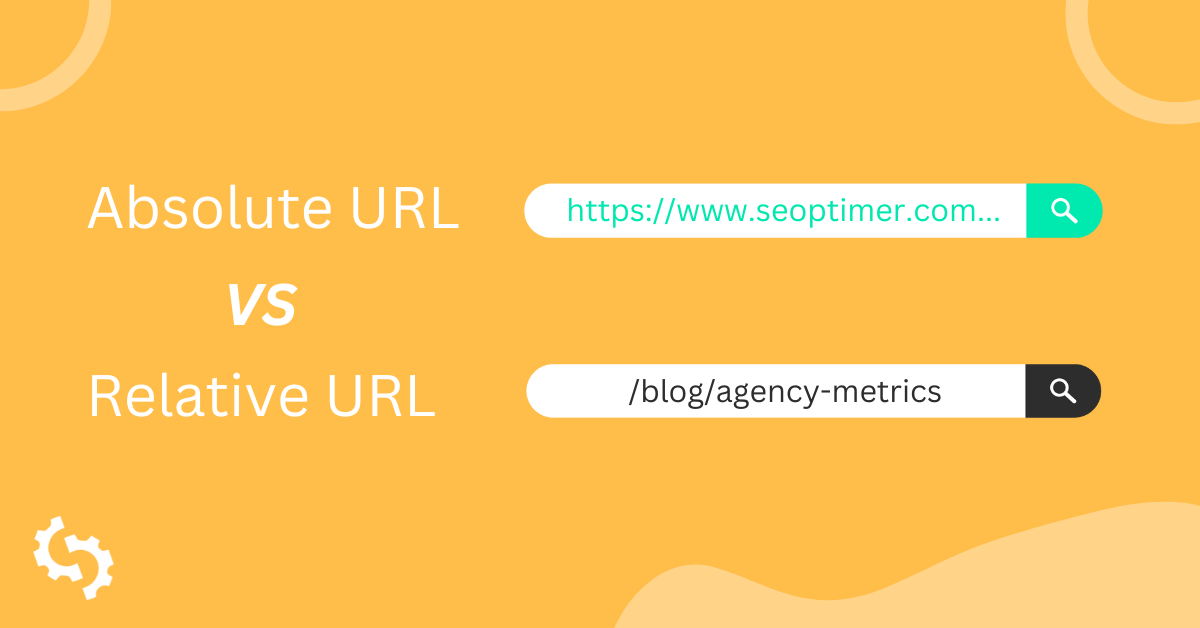

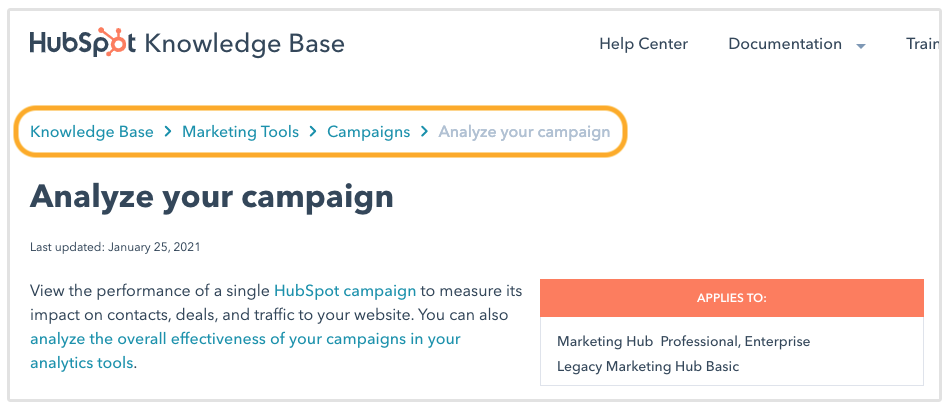

Start med at strømline dine navigationsmenuer, kategorisere indhold logisk og bruge klare, beskrivende etiketter. Opret en klar hierarki for din hjemmeside, og sørg for, at underkategorier og sider er organiseret under relevante hovedkategorier.

Implementer "breadcrumb navigation" for at guide brugere og søgemaskiner gennem din sides struktur.

Endelig, optimer din URL-struktur for at skabe rene og beskrivende URL'er og vedligeholde et opdateret XML-sitemap for at hjælpe søgemaskineindeksering.

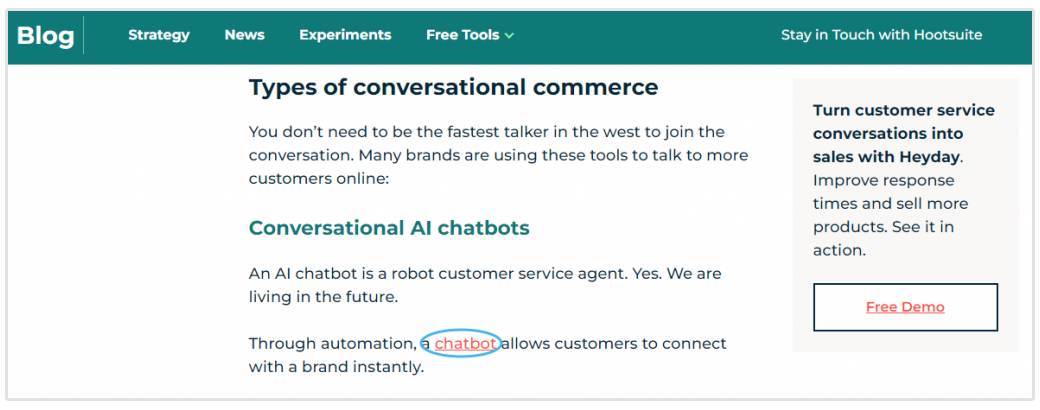

Tilføj flere interne links

Interne links er vigtige for at guide søgemaskinernes crawlere gennem din hjemmeside.

Når du tilføjer interne links strategisk i dit indhold, giver du klare veje for søgemaskinebots til at følge fra en side til en anden.

Tilføjelse af interne links til forskellige sider på dit websted giver dig mulighed for at fordele crawl-aktiviteten mere jævnt. Dette sikrer, at forskellige dele af dit websted får opmærksomhed fra søgemaskinebots, hvilket forhindrer, at nogle sider bliver overset.

Desuden opfordrer interne links søgemaskinebots til at dykke dybere ned i dit websteds hierarki. Når vigtige sider er linket fra flere kilder, signalerer det til søgemaskinerne, at de er betydningsfulde og fortjener grundig indeksering.

Forbedre webstedets ydeevne

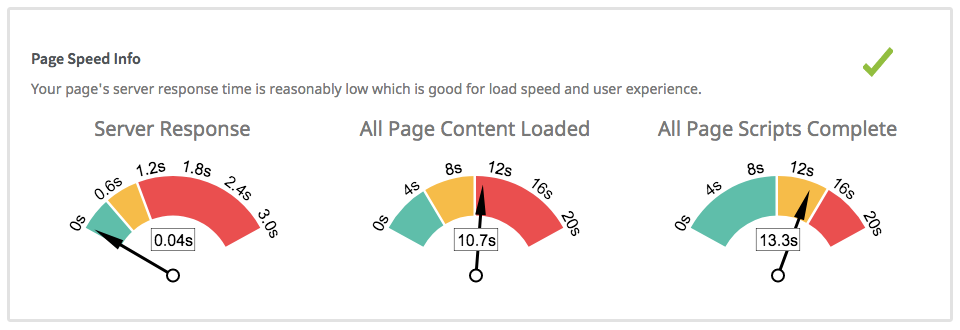

Forbedring af webstedsydelse påvirker direkte crawl-hastigheden.

En hurtigt indlæst hjemmeside med optimerede billeder, minimale HTTP-anmodninger, effektive serverresponstider og reduceret serverbelastning kan betydeligt forbedre effektiviteten af søgemaskinecrawlere.

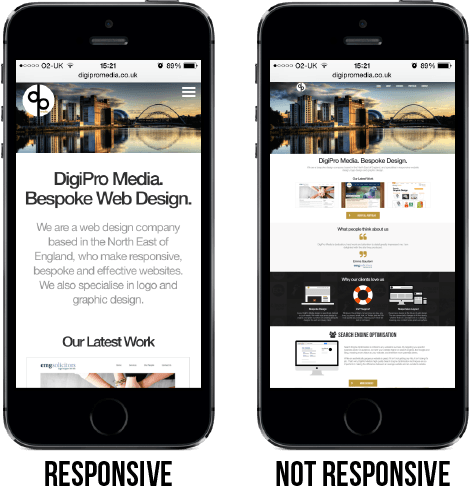

Når en hjemmeside er responsiv og indlæses hurtigt, kan søgemaskiner gennemgå dens sider hurtigere og mere effektivt. Dette betyder, at søgemaskinebots kan dække mere inden for det tildelte crawl-budget, hvilket fører til en mere omfattende indeksering af dit [site's] indhold.

Heldigvis har de fleste hjemmesidebyggere og moderne Content Management Systems mobil-responsive temaer.

Som følge heraf giver en velfungerende hjemmeside en forbedret brugeroplevelse og letter hurtigere og mere grundig søgemaskineindeksering, hvilket kan påvirke dine SEO-rangeringer positivt.

Hvad kan forårsage Crawl Depth-problemer?

Her er almindelige faktorer, der kan føre til crawl-dybdeproblemer:

- Kompleks Webstedsstruktur: Websites med alt for komplekse hierarkier og dybe navigationsstier kan gøre det udfordrende for søgemaskinebots at nå dybere sider hurtigt. Denne kompleksitet kan skyldes overdrevne underkategorier eller ineffektiv organisering.

- Utilstrækkelig intern linking: Hvis dit website mangler ordentlig intern linking, især links der peger på dybere sider, kan søgemaskinebots have svært ved at opdage og crawle disse sider. Utilstrækkelige interne links begrænser stierne for crawlere at følge.

- Forældreløse Sider: Forældreløse sider er dem uden nogen interne links, der peger på dem. Når sider er isoleret fra resten af webstedets struktur, kan søgemaskiner muligvis ikke nemt finde og indeksere dem.

- Brudte links og omdirigeringskæder: Brudte links eller forkerte omdirigeringer kan forstyrre crawling. Søgemaskinebots kan støde på blindgyder eller cirkulære omdirigeringskæder, hvilket forhindrer dem i at få adgang til dybere sider.

- Langsomme indlæsningstider for sider: Sider med langsomme indlæsningstider kan frustrere søgemaskinebots, hvilket får dem til at opgive crawl for tidligt. Langsomt indlæsende sider kan hindre indekseringen af dybere indhold.

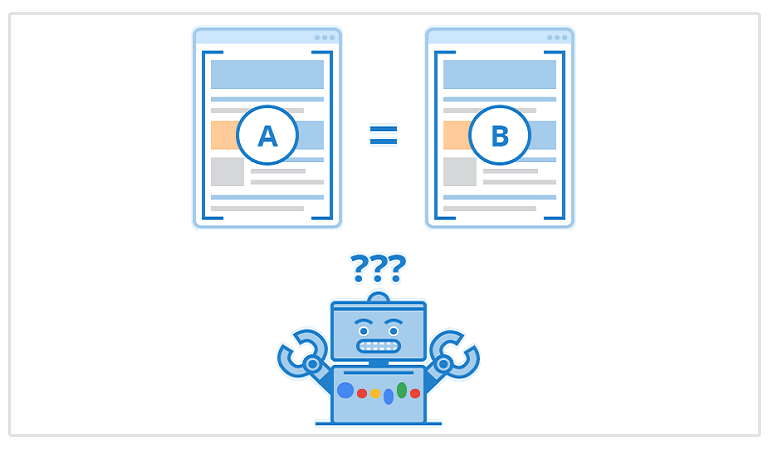

- Duplikeret indhold: Problemer med duplikeret indhold kan forvirre søgemaskinebots, hvilket fører til ineffektiv crawling. Når bots støder på flere versioner af det samme indhold, prioriterer de måske ikke at indeksere alle forekomster.

- Noindex Tags: The "noindex" meta tag or directive [instruerer] søgemaskiner til at afstå fra at indeksere bestemte sider. Når [væsentlige] sider utilsigtet har denne tag, kan det [formindske] deres tilstedeværelse i søgeresultater, hvilket potentielt kan påvirke deres synlighed.

- Changes in Website Structure: [Hyppige] ændringer i din [websites] struktur uden korrekt omdirigering eller opdatering af interne links kan forvirre søgemaskinebots. De kan forsøge at crawle ikke-eksisterende eller forældede sider.

Konklusion

Crawl dybde er afgørende for, hvordan søgemaskiner opdager og indekserer dit websteds indhold. Det påvirker indekseringseffektivitet, SEO-ydeevne, brugeroplevelse og hvor ofte Googlebot genbesøger dine sider.

Ved at optimere din hjemmesides struktur, interne links og andre tekniske aspekter, kan du sikre, at vigtigt indhold får den opmærksomhed, det fortjener fra søgemaskiner.